Infondere valori morali nei sistemi di intelligenza artificiale per migliorare l’interazione tra uomo e macchina e arricchire l’esperienza dell’utente.

Nel Pad. 3 di Maker Faire Rome il progetto “VALAWAI” al quale partecipano i Sony Computer Science Laboratories, finanziato dall’Unione Europea

I Sony Computer Science Laboratories (Sony CSL) partecipano al progetto VALAWAI, finanziato dall’UE, per lavorare a un’Intelligenza Artificiale (IA) che sia consapevole dei valori, ad esempio quelli morali. Ma cosa si intende per “consapevolezza”? Come può essere misurata? È possibile che un sistema di IA sia consapevole di alcuni valori?

Il termine “consapevole” si presta a molte sfumature di senso, ma più solitamente si riferisce all’esplicita realizzazione, alla percezione, al sapere e al conoscere qualcosa. Questo “qualcosa”, all’interno del progetto VALAWAI sono i valori umani che, semplificando, possono essere intesi come quei principi che determinano le nostre preferenze tra diversi stati del mondo, come la scelta tra cosa è giusto e sbagliato.

Allo stesso modo, un sistema di IA è consapevole dei valori quando è in grado di acquisire e mantenere un sistema di valori e di usare tale sistema per decidere quali azioni sono accettabili, adattandole ai valori dell’utente.

Poiché i valori guidano il nostro comportamento, in modo esplicito ma anche implicito, le nostre azioni sono anche espressioni dei nostri valori e riflettono la priorità che diamo loro.

Dalle nostre azioni, un sistema di IA può apprendere come adattare le proprie decisioni al nostro comportamento, allineando il proprio comportamento ai nostri valori. Ma la consapevolezza dei valori è qualcosa che va oltre il semplice allineamento “azione-valori”, poiché richiede che il sistema, non solo punti a soddisfarli ma anche a interiorizzarli nei propri processi, permettendo così di spiegare le decisioni in base a tali valori.

In VALAWAI i Sony CSL stanno sviluppando un sistema di IA modulare, in grado di combinare componenti basati su vari modelli, da quelli classici di apprendimento macchina per l’inferenza statistica, a quelli simbolici per il ragionamento basato sull’esecuzione di regole logiche. L’interpretabilità del sistema verrà stabilita dalla combinazione di questi diversi approcci. Finora, sono state già sviluppate alcune componenti specializzate nel rendere operativi i valori, come ad esempio: un rilevatore di valori dal testo, una metrica di allineamento morale, un misuratore di compatibilità tra valori morali.

Inoltre, l’approccio modulare permette a qualsiasi sviluppatore di generare nuovi sistemi, combinando le proprie componenti assieme a quelle che verranno rilasciate durante il corso del progetto.

I partner del progetto

Oltre a Sony CSL sono partner del progetto: Agencia Estatal Consejo Superior De Investigaciones Científicas di Barcellona (CSIC-IIIA), la Fundació Institut Hospital Del Mar D’investigacions Mèdiques di Barcellona (IMIM), l’Istituto Italiano di Tecnologia di Genova (IIT), l’Università di Ghent, lo Studio Stelluti di Bruxelles.

Tutti gli attori coinvolti mirano a dimostrare l’utilità di un’IA consapevole dei valori in specifici ambiti applicativi: robot sociali, protocolli medici, diffusione e fruizione delle notizie nei social media.

Un AI consapevole dei valori morali: lo studio del gruppo Infosfera a Sony CSL – Paris e Rome

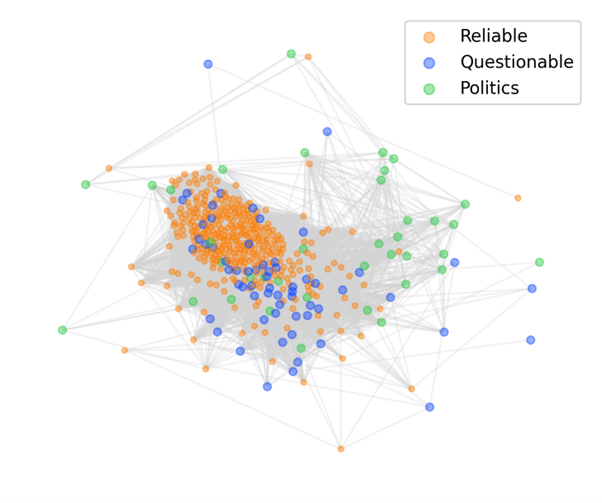

L’ultimo tema è argomento di ricerca del gruppo Infosfera a Sony CSL – Paris e Rome, che studia il ruolo dei valori morali nel contesto dell’informazione e del dibattito pubblico. Come vengono espressi i valori morali nella comunicazione delle notizie? Diversamente da come vengono invocati dalla disinformazione? Il gruppo Infosfera si interroga su questi temi con l’obiettivo di creare dei sistemi che rispettino gli standard etici, garantendo che l’informazione torni a illuminarci, piuttosto che a disorientarci. Per questo motivo è in elaborazione un’interfaccia che permetta ad un professionista dell’informazione di esplorare lo spazio delle narrazioni e delle opinioni che vengono plasmate dai media e, in futuro, si prevede di sviluppare anche un software per supportare la fruizione di notizie dai social media. Grazie a questo sistema di IA consapevole dei valori, sarà possibile spiegare quali valori morali una notizia sta convogliando e mostrare dove essa si colloca nel dibattito pubblico rispetto ad altre voci. In questo modo, si desidera promuovere la pluralità informativa e la consapevolezza, nell’utente, di essere un agente morale, guidato anch’esso dai propri valori.

Tra le teorie su cui poggia il lavoro di ricerca che i Sony CSL stanno realizzando c’è la Moral Foundations Theory (MFT) sviluppata da un team psicologi sociali e culturali e primariamente da Jonathan Haidt e Jesse Graham.

Foto copertina: L’immagine rappresenta fonti di notizie raggruppate secondo i valori morali che esprimono

Visita lo stand di Sony CSL nel Pad. 3 della Fiera di Roma e condividi la tua storia, acquista ora il tuo biglietto: https://makerfairerome.eu/it/biglietti/!

Maker Faire Rome – The European Edition, promossa dalla Camera di Commercio di Roma, si impegna fin dalla sua prima edizione a rendere l’innovazione accessibile e fruibile, offrendo contenuti e informazioni in un blog sempre aggiornato e ricco di opportunità per curiosi, maker, PMI e aziende che vogliono arricchire le proprie conoscenze ed espandere la propria attività, in Italia e all’estero.

Seguici sui nostri social (Facebook, Instagram, Twitter, LinkedIn, Youtube) e iscriviti alla newsletter per ricevere aggiornamenti, sconti, agevolazioni per organizzare al meglio la tua partecipazione.