Sviluppo dell’Intelligenza Artificiale: bastano le tre leggi di Asimov?

L’evoluzione della tecnologia riporta al centro del dibattito le questioni etiche. E’ il momento di dare al nostro rapporto con l’Intelligenza Artificiale nuove regole.

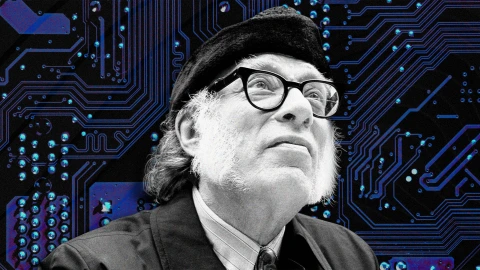

Lo sviluppo dell’Intelligenza Artificiale viaggia a velocità mai viste prima. ChatGPT è in assoluto la tecnologia che ha scalato più velocemente, e non accenna a rallentare. Non sorprenderà, quindi, che in questo contesto da più parti si invochi una riflessione sugli aspetti etici. Le tre leggi della robotica di Isaac Asimov, più che sufficienti fino ad oggi, tornano ora al centro del dibattito e ci si chiede se possano rappresentare ora ‘soltanto’ dei pilastri guida per la costruzione di un vero e proprio ecosistema uomo-macchina sostenibile e responsabile.

Le tre leggi della robotica

Le tre leggi della robotica sono state formulate dal biochimico e scrittore sovietico (naturalizzato statunitense) Isaac Asimov nel 1942, nello stesso racconto in cui appare per la prima volta la parola ‘robotica’ (Runaround, incluso nella raccolta I Robot, pubblicata nel 1950).

Queste leggi regolano l”intelligenza’ dei robot dei robot:

- Un robot non può recare danno agli esseri umani, né può permettere che, a causa del suo mancato intervento, gli esseri umani ricevano danno

- Un robot deve obbedire agli ordini impartiti dagli esseri umani, tranne nel caso che tali ordini contrastino con la Prima Legge.

- Un robot deve salvaguardare la propria esistenza, purché ciò non contrasti con la Prima e la Seconda Legge.

In I Robot e l’Impero (1985), Asimov aggiunge poi la Legge Zero, che però è accettata solo dai robot più sofisticati. Questa legge è anteposta, in ordine di importanza, alle altre, permettendo una maggiore efficienza ai robot:

0. Un robot non può recare danno all’Umanità, né può permettere che, a causa del suo mancato intervento, l’Umanità riceva un danno.

Le implicazioni etiche della AI sulla nostra società, nelle leggi di Asimov

Un’analisi approfondita delle tre leggi di Asimov rivela le implicazioni etiche delle azioni dei robot – e dell’intelligenza artificiale – sulla nostra società.

La prima legge afferma che un robot non può ferire un essere umano o permettere che questi subisca danni a causa della sua inazione. Si amplia, dunque, la prospettiva di una singola causa-effetto e si impone una responsabilità per le conseguenze indirette delle azioni del robot. Ciò permette di delineare anche una sorta di reato di ‘omissione di soccorso’.

La seconda legge, secondo la quale un robot deve obbedire agli ordini degli esseri umani, a meno che tali ordini non siano in contrasto con la prima legge, pone il principio della sottomissione dell’intelligenza artificiale al volere umano e lascia intravedere, come conseguenza, una sottoposizione al servizio del progresso e del benessere dell’umanità.

Infine, la terza legge, garantendo l’autoprotezione dei robot, se non quando in contrasto con la prima e/o la seconda legge, stabilisce, se interpretata estensivamente e in relazione alle due leggi precedenti, che essi devono essere concepiti e sviluppati in modo sostenibile. I robot devono dunque essere realizzati per durare a lungo e avere un impatto minimo sull’ambiente, in modo che la loro presenza non vada a detrimento della terra e delle sue risorse, ma si armonizzi con gli ecosistemi in cui essi operano.

Il ruolo delle leggi nella regolamentazione e nella ricerca

Seppur definite nel 1942 e inizialmente rivolte a un pubblico di lettori di fantascienza, le tre leggi della robotica trovano oggi applicazioni concrete e rilevanti, sia nella regolamentazione del settore che negli sviluppi della ricerca.

Le recenti discussioni sui limiti etici delle armi autonome e sull’integrazione dell’AI nelle decisioni mediche, per esempio, si basano implicitamente o esplicitamente sui principi etici espressi nelle leggi della robotica. Così come anche l’appello recentemente lanciato da Elon Musk e da altri esperti e leader del settore dell’intelligenza artificiale. Recentemente, a fine aprile 2023, anche Geoffrey Hinton, considerato il ‘padrino dell’intelligenza artificiale’ per i suoi studi sulle reti neurali, si è dimesso da Google proprio per poter parlare liberamente dei rischi dell’IA.

Le storie di Asimov e le sue leggi ci hanno mostrato quanto sia difficile, persino impossibile, ‘regolamentare’ in modo sereno, senza problemi, e controllare cosi qualsiasi intelligenza. Lo sapevamo già ma Asimov ha confermato che, data una legge, ci sarà sempre una scappatoia o un’eccezione. Di contro, tutte le leggi hanno bisogno di margine di manovra e flessibilità, altrimenti si rivelano inefficaci (o, peggio, finiscono col danneggiare coloro che stanno cercando di proteggere).

Come afferma un recente articolo pubblicato sulla rivista Science Robotics, le storie di Asimov “mettono in guardia contro l’improbabilità di ‘regolare’, semplicemente, la progettazione o la gestione di ecosistemi di macchine complesse, esseri umani e loro interazioni”. Forse anche di questo dovremmo avere piena consapevolezza.

La quarta legge della robotica

Mentre ci avviciniamo velocissimamente ad un mondo nel quale l’Intelligenza Artificiale farà alcune cose meglio degli umani, la maggior parte di noi vuole ancora sapere cosa è – e cosa non è – opera di una intelligenza artificiale. E’ importante sapere che se ciò che stiamo leggendo è scritto da un essere umano, o se lo è chi mi sta chiamando per propormi di attivare un servizio a pagamento. Vogliamo ancora sapere se una poesia, una canzone, un articolo, un’opera d’arte sono stati realizzati da un robot o da un essere umano.

Secondo il prof. Jonny Thompson, docente di filosofia a Oxford, forse Asimov ha mancato una quarta legge essenziale: un robot deve identificarsi. Secondo lui, abbiamo il diritto di sapere se stiamo interagendo con un essere umano o con un’intelligenza artificiale.

Un nuovo ecosistema uomo-macchina

Nel frattempo, la ricerca sull’AI etica e sull’apprendimento profondo (deep learning) incoraggia la creazione e l’approfondimento di tecnologie che valutino e integrino queste leggi nella loro progettazione e nel loro funzionamento, guidando progressivamente la costruzione di uno spazio di interazione sano tra umani e robot.

Le leggi di Asimov hanno influenzato gli sviluppatori di robotica per decenni, ma molti ora si stanno chiedendo se non sia venuto il momento di rivalutare la loro coerenza, e stanno tentando di riscriverle in funzione delle nuove scoperte e delle innovazioni intervenute in questo settore.

Ci ha provato il prof. Frank Pasquale, docente alla Brooklyn Law School ed esperto di diritto di IA, ha scritto un libro dal titolo, “New laws of robotics: defending human expertise in the age of AI”, in cui propone un aggiornamento e una revisione alle tre leggi della robotica di Asimov.

In questo libro senza precedenti, Frank Pasquale ripensa alle leggi della Robotica introducendone di nuove per permettere alla rivoluzione digitale di non trasformarsi in una trappola senza ritorno per il genere umano. Per Frank Pasquale è necessario regolamentare il comportamento di robot, intelligenze aumentate e intelligenze artificiali, soprattutto quando intervengono in ambienti legati alla salute, alla giustizia, al lavoro e ai conflitti (guerre comprese).

Lo fa secondo quattro principi che il ricercatore ritiene fondamentali:

- I sistemi robotici e le AI devono essere complementari ai professionisti e non sostituirli

- I sistemi robotici e le AI non devono contraffare l’umanità

- I sistemi robotici e le AI non devono intensificare una somma agli armamenti a somma zero

- I sistemi robotici e le AI devono sempre indicare l’identità dei loro creatori, controllori e proprietari

Frank Pasquale è professore di diritto alla Brooklyn Law School e autore di The Black Box Society: The Secret Algorithms That Control Money and Information. Il suo lavoro è apparso su testate quali Atlantic, New York Times, Los Angeles Times, Guardian.

In questo video, una sua intervista a cura del Prof. Juan Carlos De Martin in un webinar nell’ambito della rassegna Biennale Tecnologia del Politecnico di Torino:

fonti: AI News (Paolo Marinoni) I Business Intelligence Group

Immagine di copertina: iCub I credit: IIT

Maker Faire Rome – The European Edition, promossa dalla Camera di Commercio di Roma, si impegna fin dalla sua prima edizione a rendere l’innovazione accessibile e fruibile, offrendo contenuti e informazioni in un blog sempre aggiornato e ricco di opportunità per curiosi, maker, PMI e aziende che vogliono arricchire le proprie conoscenze ed espandere la propria attività, in Italia e all’estero.

Le nostre Call sono aperte: se anche tu hai un progetto brillante, innovativo e inedito che vorresti presentare a #MFR2023 scopri la Call for Makers, la Call for Schools e la Call for Universities & Research Institutes. Scegli quella che fa per te e invia la tua proposta entro il 31 maggio: se sarai selezionatə , potrai presentarla al pubblico di Maker Faire Rome, dal 20 al 22 ottobre.